By accepting you will be accessing a service provided by a third-party external to https://www.incgmedia.com/

輸入音樂即可生成舞蹈動作!一窺超強 AI 技術如何改變現有的創作流程

舞蹈作為表演藝術之一,擁有非常複雜的流派與表現方式,一般人練舞都需要耗時多年,更何況是用 CG 技術創造舞蹈。然而日前,專門討論物理學、數學、電腦科學、生物學及數理經濟學的知名論壇「arXiv」上,幾位來自史丹佛大學的學生與教授 Jonathan Tseng、Rodrigo Castenllon 和 C. Karen Liu 共同發表了一款最先進的舞蹈編輯生成工具「EDGE(Editable Dance Generation From Music)」,它能透過音樂自動生成逼真且合乎物理定律的舞蹈,同時保持輸入音樂的保真度,趕快跟著映CG 來看看它的強大功能吧!

invalid quix collection shortcode!

將擴散模型搭配 Jukebox,創造出各式舞蹈

EDGE 將 transformer 架構的擴散模型(Diffusion Model)搭配 一款強大的音樂提取器 Jukebox,它大的編輯功能可以創作合適的舞蹈,包括智慧關節調整、預定動作起舞/結束以及舞蹈動作的延續等等。此外,他們還加入全新的物理定律指標,並透過以下兩種方式評估 EDGE 所生成的舞蹈品質:

1. 指標:關於物理定律、節拍對齊、多樣性基準等多個定量指標。

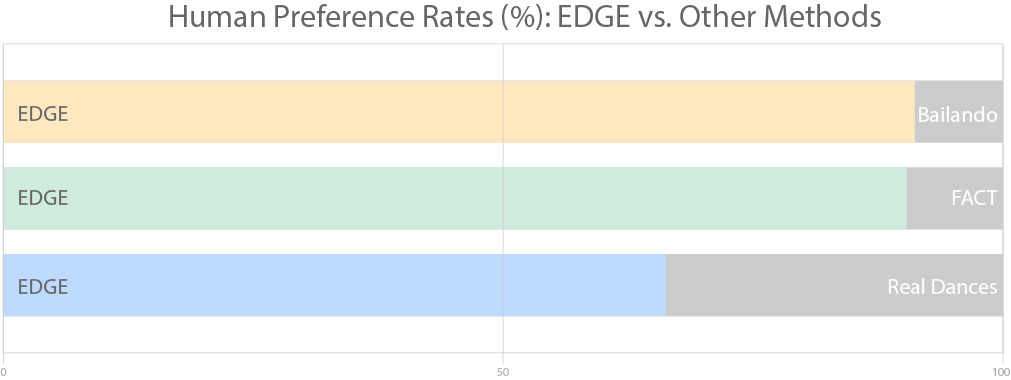

2. 研究:透過大規模的使用者研究,證明比以往最先進的方法擁有更顯著的改善。

以特定音樂為基礎,所設計的 100 種舞蹈樣本

儘管 EDGE 只能生成約五秒左右的舞蹈片段,但它能透過將時間限制(temporal constraints)強制執行在一組序列(batch of sequence)上,以生成任意長度的舞蹈。下圖為 EDGE 限制每組序列的前半部分,以搭配上一序列的的後半部分。此外,EDGE 會透過 Jukebox 將輸入的音樂進行編碼,接著條件式擴散模型(Conditional Diffusion Model)會將編碼後的音樂導入進各個舞蹈片段中,並將其串聯成一部完整的影片,過程中系統還會自動調整動作和時間的連貫性。

EDGE 會使用 Jukebox 生成的音樂來獲得廣泛的數據,藉此創造出高品質的舞蹈,且即使透過原生的音樂樣本也能達到一樣的效果。

可隨使用者任意編輯合成

EDGE 不受任何時間與空間上的限制影響,且可用於支援許多終端使用者的程式,包括:

1. 透過在多組序列之間執行時間連續性(temporal continuity),以創造出任意長度的舞蹈

2. 舞蹈動作跟關節有很大的關聯,也就是下半身會帶動上半身的肢體動作,反之亦然。

3. 以預定的動作來設定所有舞蹈動作的開始與結束。

4. 由同一個預定姿勢開始跳舞,但後續動作皆不一樣。

智慧關節,系統會自動生成下半身以帶動上半身

智慧關節,系統會自動生成上半身以帶動下半身

以同樣的舞蹈動作來開始與結束

由同一個預定姿勢開始,但後續的動作皆不同

合乎物理定律的舞步

由於舞蹈中充滿著滑動腳步等複雜且有意的動作,所以 EDGE 會使用新的 Contact Consistency Loss 功能,以學習該滑動的時機,並在滑動過程中提高物理的真實感。此外,開發團隊將 EDGE 與 Bailando 及 FACT 等動作生成方式相比,發現前者的接受度高出許多。

EDGE 會避免意外腳滑的狀況,並在設定時將現實中的物理定律納入參考。

據官方消息指出,目前該研究還在開發階段,點此可了解更多。